तुमच्या फोनवर स्थानिक एआय ब्राउझर कसा सेट करायचा

गेल्या काही वर्षांमध्ये, जनरेटिव्ह AI ने मुख्य प्रवाहात डिजिटल उत्पादनांमध्ये प्रवेश केला आहे ज्यांना आपण दररोज ढकलतो. ईमेल क्लायंटपासून ते संपादन साधनांपर्यंत, हे साधनांच्या विस्तृत श्रेणीमध्ये खोलवर रुजलेले आहे. वेब ब्राउझर अपवाद नाहीत. पण AI च्या ओतण्याने शोषण केलेल्या गोपनीयतेचा छळ दिसतो. मला माझी सर्वात असुरक्षित ChatGPT संभाषणे OpenAI च्या सर्व्हरमधून जावीत किंवा माझ्या फायली Microsoft च्या Copilot सर्व्हरवर काही महिने राहाव्यात असे मला वाटते का? बऱ्याच वापरकर्त्यांसाठी, उत्तर दणदणीत नाही आहे. परंतु त्याच वेळी, ब्राउझरमध्ये AI टाळणे अधिक कठीण होत आहे, विशेषत: ऑफरवरील सोयीच्या पार्श्वभूमीवर.

तिथेच स्थानिक AI ब्राउझर चित्रात येतात. त्यांचा एक नियमित वेब ब्राउझर म्हणून विचार करा, परंतु क्लाउड सर्व्हरवर तुमच्या क्वेरी पाठवण्याऐवजी AI सहाय्यक पूर्णपणे तुमच्या डिव्हाइसवर चालतो. सर्वसाधारणपणे, हे Pixel 10 Pro वर जेमिनी नॅनोशी संवाद साधण्यासारखे आहे, जेथे Google चे AI इंटरनेट कनेक्शनची आवश्यकता नसतानाही काही कामे हाताळू शकते. परंतु स्थानिक ब्राउझरवर ऑन-डिव्हाइस AI वापरणे ही सरळ प्रक्रिया नाही. परंतु अधिक महत्त्वाचे म्हणजे, तुम्हाला एक ब्राउझर निवडणे आवश्यक आहे जे तुम्हाला डिव्हाइसवर स्थानिकरित्या एआय मॉडेल चालवू देते. समुदायाच्या फीडबॅकच्या आधारे, सर्वात धमाकेदार स्थानिक AI ब्राउझर Puma असल्याचे दिसते.

Android आणि iOS वर उपलब्ध, हा गोपनीयता-केंद्रित ब्राउझर वापरकर्त्यांना Google च्या गडापासून दूर जाऊ देतो आणि तुम्हाला तुमची शोध इंजिन म्हणून Ecosia आणि DuckDuckGo दरम्यान निवडू देतो. अधिक महत्त्वाचे म्हणजे, ते तुम्हाला Llama 3.2, Ministral, Gemma आणि Qwen मालिका AI मॉडेल्सची स्थानिक उदाहरणे पूर्णपणे डिव्हाइसवर चालवू देते. त्यामुळे, सामान्य ज्ञानाची क्वेरी असो किंवा रीस्टाईल करणे आणि सारांश काढणे यासारखे हाताचे काम असो, कोणताही परस्परसंवाद तुमचा फोन सोडत नाही.

सेटअप

जेव्हा तुम्ही प्रथम Puma ब्राउझर स्थापित करता, तेव्हा त्यात आधीपासूनच Meta चे ओपन-सोर्स Llama 3.2 मॉडेल सेट अप आणि चालू असते. परंतु तुम्हाला दुसरे एआय मॉडेल डाउनलोड करायचे असल्यास, या चरणांचे अनुसरण करा:

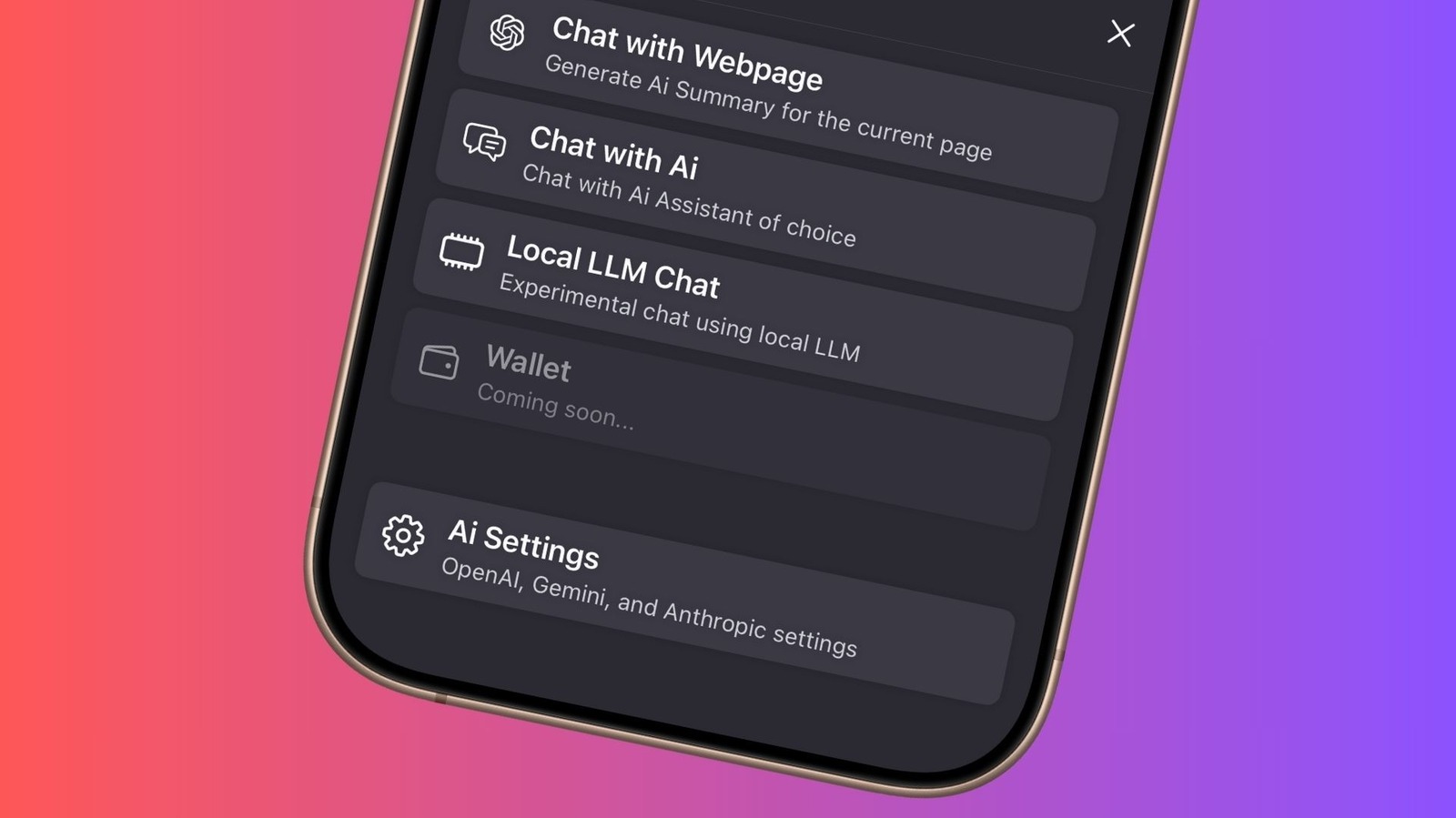

- ब्राउझरच्या मुख्यपृष्ठावर, तळाशी असलेल्या Puma चिन्हावर टॅप करा.

- पॉप अप होणाऱ्या स्लाइडर मेनूमध्ये, स्थानिक LLM चॅट पर्यायावर टॅप करा.

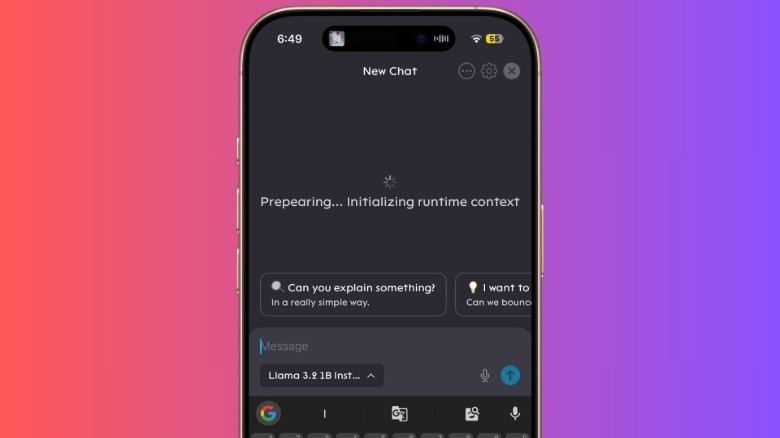

- चॅट पृष्ठावर, संगीतकार फील्डमध्ये “Llama 3.2 1B” असे म्हणणाऱ्या बटणावर क्लिक करा.

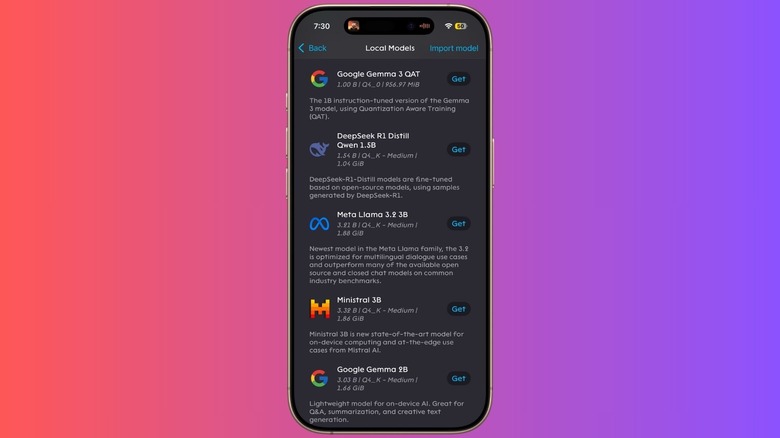

- त्यावर टॅप केल्याने उपलब्ध स्थानिक एआय मॉडेल्सची सूची उघडते. पहिल्या स्थापनेनंतर, फक्त Llama 3.2 1B सूचना उपलब्ध आहे. “अधिक मॉडेल” पर्याय निवडा.

- पुढील पृष्ठावर, तुम्हाला मॉडेल्सची संपूर्ण यादी दिसेल, ज्यात Google Gemma, Mistral, DeepSeek, Qwen, Microsoft Phi आणि बरेच काही समाविष्ट आहे. तुमच्या पसंतीच्या एआय मॉडेलशी संबंधित “मिळवा” बटण निवडा आणि ते डाउनलोड आणि स्थापित केले जाईल.

बऱ्याच मॉडेल्सचा आकार 1GB पेक्षा जास्त आहे, त्यामुळे त्यांना तुमच्या फोनवर डाउनलोड आणि इंस्टॉल होण्यासाठी थोडा वेळ लागेल. आणि नक्कीच, आपण जितके अधिक साहसी व्हाल तितके जास्त स्टोरेज ते हॉग करणार आहेत. AI मॉडेल कॉन्फिगर केल्यावर, तुम्ही स्थानिक LLM चॅट पर्यायावर परत जाऊ शकता, तुमच्या आवडीचे मॉडेल निवडू शकता आणि संभाषण सुरू करू शकता.

आता, मोठा प्रश्न असा आहे की, जेव्हा तुम्ही चॅटजीपीटी किंवा जेमिनी ॲप्स वापरू शकता तेव्हा तुम्हाला स्थानिक एआय मॉडेल का हवे आहे? किंवा Android फोनवर जेमिनीला डीफॉल्ट असिस्टंट म्हणून बोलावून किंवा तुमच्या iPhone वर ChatGPT (Siri आणि Apple Intelligence द्वारे) बोलवून ते पूर्णपणे टाळायचे? बरं, गोपनीयता हे स्पष्ट उत्तर आहे. तथापि, असे काही वेळा असतात जेव्हा तुमच्याकडे इंटरनेट कनेक्शन नसते किंवा फोकस केलेल्या कामासाठी फक्त ऑफलाइन मोड सक्षम केलेला असतो. अशा परिस्थितींसाठी, हे स्थानिक एआय मॉडेल्स उपयुक्त आहेत कारण ते कोणत्याही कनेक्शन आवश्यकतांशिवाय त्यांचे काम हाताळू शकतात. फक्त एकच चेतावणी आहे की ते स्थानिक पातळीवर प्रतिमा निर्मितीसारख्या स्नॅझी युक्त्या काढू शकत नाहीत. शिवाय, Google AI Edge Gallery ॲपच्या विपरीत, Puma ब्राउझर तुम्हाला CPU आणि GPU वर AI वर्कलोड सानुकूलित करू देत नाही किंवा रोपटी आणि तापमान यांसारखे पैलू समायोजित करू देत नाही.

Comments are closed.